UniToken是什么

UniToken 是新型的自回归生成模型,专为多模态理解与生成任务设计。通过结合离散和连续的视觉表示,构建了一种统一的视觉编码框架,能同时捕捉图像的高级语义和低级细节。使 UniToken 可以无缝支持视觉理解和图像生成任务,为不同任务提供多维度信息。

UniToken的主要功能

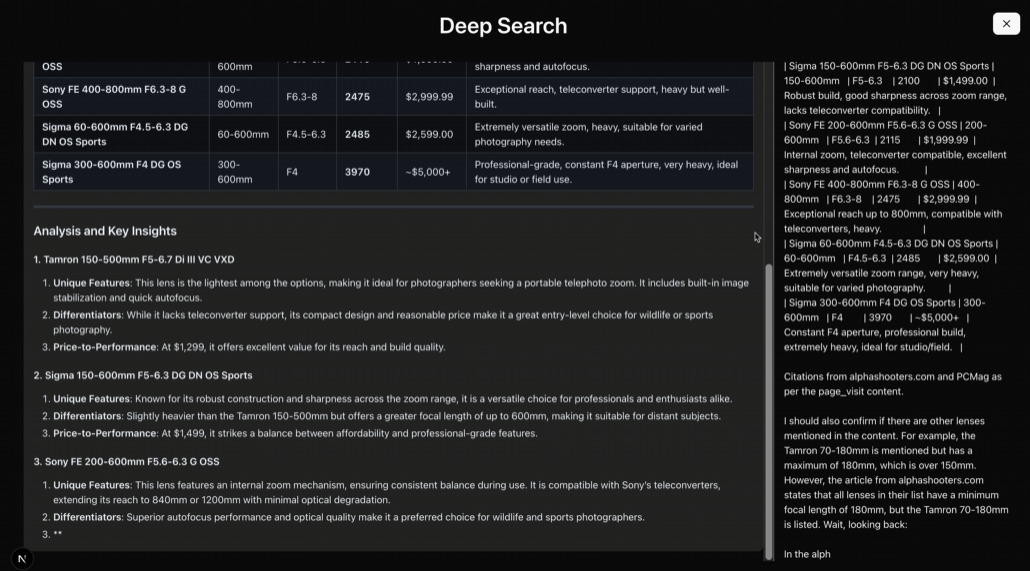

图文理解:UniToken 能高效处理图文理解任务,例如图像字幕生成和视觉问答(VQA)。

图像生成:UniToken 支持高质量的图像生成任务,包括根据文本描述生成图像、图像编辑以及故事生成等。

多模态对话:在多模态对话场景中,UniToken 可以根据输入的文本和图像信息生成自然语言回复,支持更复杂的交互任务,例如解释图像内容或根据图像和文本指令生成新的图像。

复杂指令跟随:UniToken 通过指令强化微调,能更好地理解和执行复杂的多模态指令,例如在给定文本描述和图像的情况下生成特定布局的图像。

细粒度视觉任务:借助 AnyRes 和 ViT 端到端微调等技术,UniToken 能处理高分辨率图像,提升对图像细节的感知能力,适用于需要高精度视觉处理的任务。

任务通用性:UniToken 能无缝整合多模态理解与生成任务,支持图文理解、图像生成、图像编辑、故事生成等多种复杂任务,展现出强大的通用生成能力。

UniToken的技术原理

统一视觉编码:UniToken 采用连续和离散双编码器,将 VQ-GAN 的离散编码与 SigLIP 的连续表征相结合,生成兼备高层语义和底层细节的视觉编码,能够为多模态大模型提供完备的视觉信息。

多阶段训练

视觉语义空间对齐:基于 Chameleon 作为基座,冻结语言模型(LLM),仅训练 SigLIP ViT 和 Adapter,使连续视觉编码与语言空间对齐。

多任务联合训练:在大规模图文理解与图像生成数据集上联合训练,通过控制数据配比,均衡提升模型在理解与生成任务上的性能。

指令强化微调:引入高质量多模态对话和精细化图像生成数据,进一步增强模型对复杂指令的跟随能力。

细粒度视觉增强:UniToken 支持 AnyRes 和 ViT 端到端微调等技术,提升对高分辨率图像的细粒度感知能力,同时避免模型崩溃,适应广泛任务场景。

UniToken的项目地址

Github仓库:https://github.com/SxJyJay/UniToken

arXiv技术论文:https://arxiv.org/pdf/2504.04423

UniToken的应用场景

内容创作与设计:UniToken 可以根据文本描述生成高质量的图像,帮助设计师快速生成创意草图或概念图,节省设计时间和精力。

智能客服与虚拟助手:在多模态对话场景中,UniToken 能理解用户输入的文本和图像信息,生成自然语言回复。

教育与学习:UniToken 可以用于教育领域,帮助学生更好地理解和学习复杂的概念。例如,通过生成与科学实验、历史事件或文学作品相关的图像,UniToken 可以增强学生的视觉记忆和理解能力。

医疗与健康:在医疗领域,UniToken 可以用于生成医学图像或解释医学影像。

自动驾驶与交通管理:UniToken 可以用于自动驾驶场景中的视觉问答(VQA)任务。例如,车辆可以实时上传道路图像,通过 UniToken 生成关于路况、交通标志等信息的自然语言描述,辅助自动驾驶系统做出更准确的决策。