StreamBridge是什么

StreamBridge 是苹果公司与复旦大学联合推出的端侧视频大语言模型(Video-LLMs)框架,能帮助 AI 实时理解直播流视频。框架基于内存缓冲区和轮次衰减压缩策略支持长上下文交互,引入轻量级激活模型实现主动响应功能。研究团队推出包含约 60 万个样本的 Stream-IT 数据集,提升流式视频理解能力。在主流离线模型如 LLaVA-OV-7B、Qwen2-VL-7B 和 Oryx-1.5-7B 上的测试显示,StreamBridge 显著提升模型在多轮实时理解和主动响应方面的能力,在流式视频理解领域展现出强大潜力。

StreamBridge的主要功能

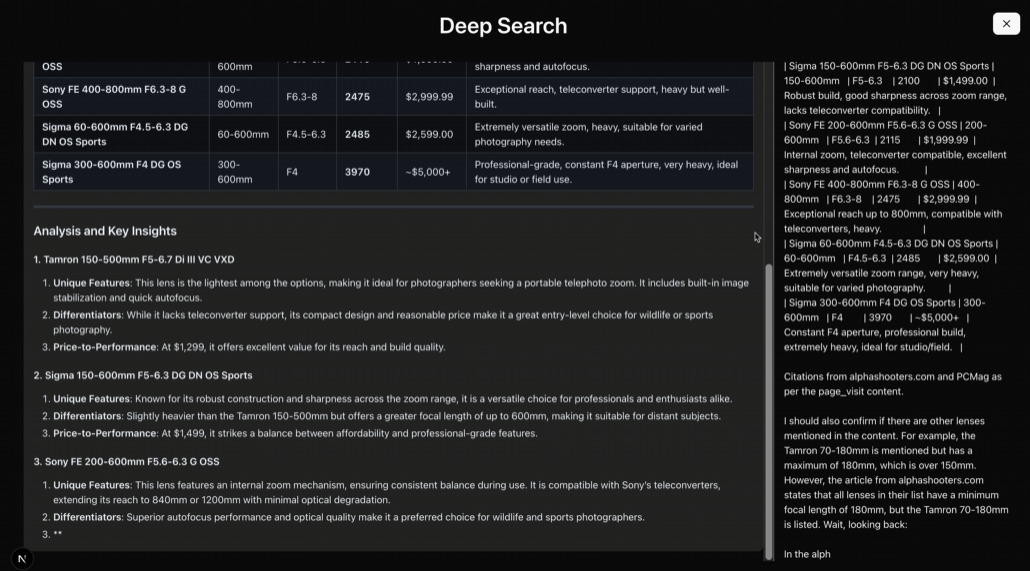

多轮实时理解:支持长上下文的多轮交互,在处理最新视频片段时保留历史视觉和对话上下文。

主动响应:模型能像人类一样主动监控视频流,在无明确指令的情况下及时输出反馈。

灵活集成:支持无缝集成到现有的视频大语言模型中,无需对基础模型进行大规模修改。

数据支持:提供大规模的流式视频理解数据集Stream-IT,包含约60万个样本,支持多样化的指令格式,用在训练和优化模型。

StreamBridge的技术原理

记忆缓冲区:存储和检索视频帧的嵌入信息,支持多轮交互。每个新视频帧被独立编码追加到缓冲区中。当接收到用户查询时,缓冲区中的内容被扁平化为一个单一的输入嵌入序列,送入语言模型进行响应生成。

轮次衰减压缩策略:在每次响应生成之前,如果输入嵌入的长度超过预定义的最大长度,模型从最早的对话轮次开始,逐帧合并视觉标记,直到总长度低于最大长度。合并操作基于平均池化实现,确保最近的视觉上下文被保留。

轻量级激活模型:激活模型是独立的轻量级多模态大语言模型(MLLM),与主视频大语言模型并行运行。激活模型接收当前帧(及用户查询和可选的前几帧)作为输入,输出一个二进制信号,指示主模型是否生成响应。激活模型用一个得分头进行二分类(是否响应),在训练时引入一个可学习的激活标记<ACT>,监督激活时机。

Stream-IT数据集:基于从大规模视频字幕语料库中筛选语义相关的短片段,生成多轮问答序列,模拟真实的实时用户交互。数据集包含约60万个样本,支持多种任务格式,如密集视频字幕、顺序步骤识别、基于视频的问题回答等。

StreamBridge的项目地址

arXiv技术论文:https://arxiv.org/pdf/2505.05467

StreamBridge的应用场景

实时视频交互:提升视频会议、在线教育等场景的实时互动体验。

自动驾驶辅助:实时处理路况视频,辅助自动驾驶决策。

智能监控:实时分析监控视频,快速发现异常行为。

机器人视觉:助力机器人实时理解环境,实现自然交互。

内容创作:辅助视频创作和编辑,提供实时内容分析。