Chinese-LiPS是什么

Chinese-LiPS 是智源研究院联合南开大学共同打造的高质量中文多模态语音识别数据集,包含100小时的语音、视频和手动转录文本,创新性地融合了唇读视频和演讲者的幻灯片内容。幻灯片由领域专家精心设计,确保了视觉图像的高质量和丰富性。数据集通过结合唇读和幻灯片信息,提升了语音识别性能,实验表明,唇读信息和幻灯片信息分别可提升ASR性能约8%和25%,两者结合可提升约35%。面向中文讲解、科普、教学、知识传播等复杂语境。

Chinese-LiPS的主要功能

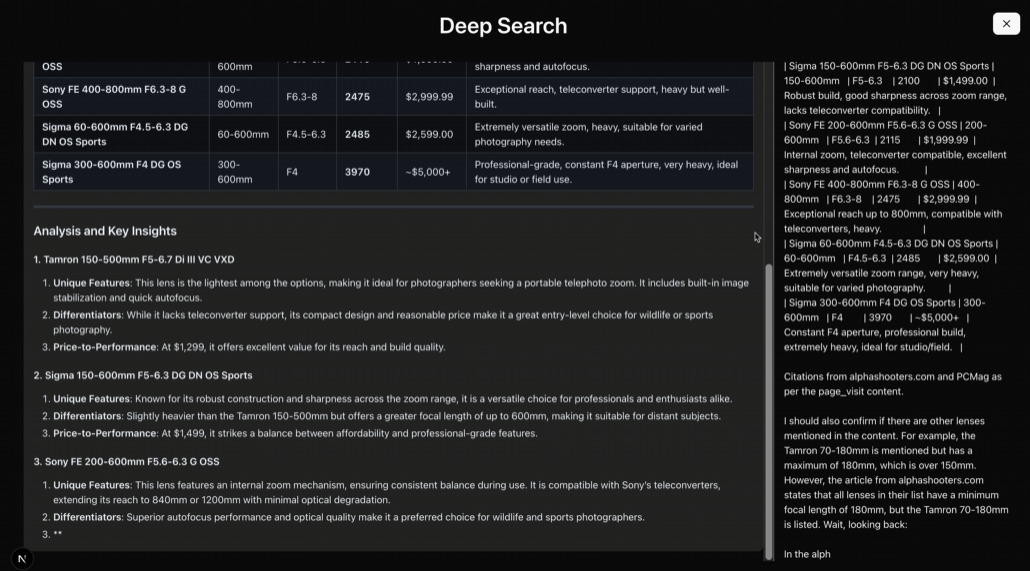

提升语音识别性能:数据集通过融合唇读信息和幻灯片语义信息,显著提升了语音识别系统的性能。实验结果显示,唇读信息可使字符错误率降低约8%,幻灯片信息可降低约25%,两者结合则可降低约35%。

减少错误类型:唇读信息在减少删除错误方面发挥了重要作用,能捕捉到与发音相关的细节,有效补充语音识别中容易缺失的部分,如填充词、因犹豫而未完整表达的语音片段等。幻灯片信息则显著降低了替换错误,丰富的语义和上下文信息,在面对专业词汇、地名等具有特定领域属性的词汇识别时,为模型提供关键的识别线索。

提供高质量多模态数据:作为一个高质量的多模态中文语音识别数据集,包含100小时的语音、视频和相应的手动转录,涵盖了唇读视频和演讲者的幻灯片,使音频视觉语音识别任务得到了更全面的探索。

Chinese-LiPS的技术原理

多模态数据融合:数据集将语音、唇读信息、通过OCR技术从幻灯片提取的文本以及从图像和图形内容中获取的语义信息进行融合。多模态信息的结合,为语音识别模型提供了更丰富的上下文和线索,显著提升了识别的准确性和鲁棒性。

唇读信息的作用:唇读能捕捉到与发音相关的细节,如填充词、因犹豫而未完整表达的语音片段等容易在语音识别中缺失的部分,借助唇读信息可有效补充,减少删除错误。

幻灯片信息的作用:幻灯片中包含丰富的语义和上下文信息,在面对专业词汇、地名等具有特定领域属性的词汇识别时,能为模型提供关键的识别线索,大幅降低替换错误。

Chinese-LiPS的项目地址

项目官网:https://data.baai.ac.cn/datadetail/Chinese-LiPS

Github仓库:https://github.com/flageval-baai/Chinese-LiPS

HuggingFace模型库:https://huggingface.co/datasets/BAAI/Chinese-LiPS

arXiv技术论文:https://arxiv.org/pdf/2504.15066

Chinese-LiPS的应用场景

虚拟教师:数据集能帮助制作互动式语言学习材料,使虚拟教师的讲解更生动。通过融合唇读信息和幻灯片语义信息,虚拟教师可以更自然地呈现教学内容,提高教学效果。

智能辅导:在智能辅导系统中,基于多模态语音识别技术,能更准确地理解学生的问题和需求,提供更个性化的辅导方案。

博物馆、展览馆讲解:在博物馆、展览馆等场所,虚拟讲解人可以用数据集提供的多模态信息,更生动、准确地介绍展品和展览内容,提升观众的参观体验。

企业产品介绍:企业可以用数据集制作虚拟讲解人,用于产品介绍、培训等场景,提高信息传递的效率和准确性。