对于 DeepSeek-R1 在日常办公使用,直接在官方网站中使用是最佳选择,如果你有其他顾虑或特殊需要…必须在 本地部署 DeepSeek-R1(附一键安装包),这里的小白教程十分适合你。

如果你的电脑配置较差,但是还想部署使用私有化 DeepSeek-R1 …那么可以考虑使用免费GPU,好久前教大家 使用免费 GPU 算力在线部署 DeepSeek-R1 开源模型,有一个致命缺点,就是免费GPU只能安装14B,安装32B会十分卡,但经过实测只有安装 DeepSeek-R1 32B以上输出质量才能达到日常工作需要。

所以…我们要做的是在免费GPU中安装高效运行的 DeepSeek-R1 32B的量化版。他来了!

(adsbygoogle = window.adsbygoogle || []).push({});

在免费GPU中可以做到每秒输出2~6个单词(根据问题复杂程度输出速度有浮动),这个方法缺点是需要不定时开启服务。

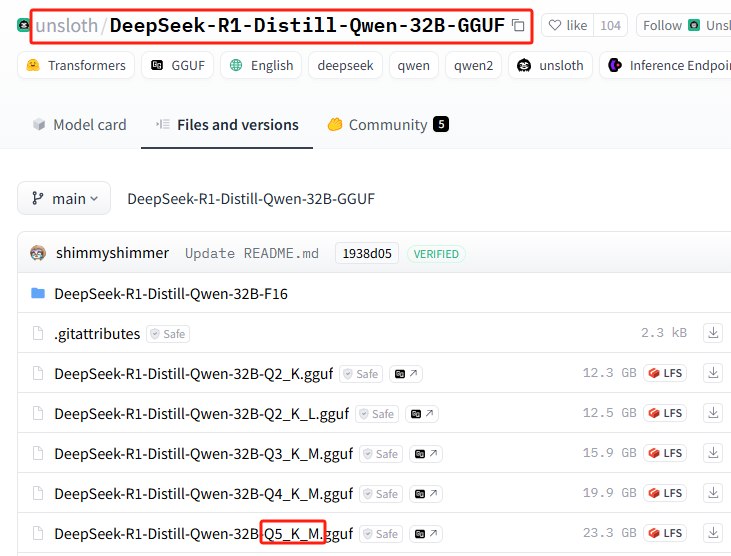

unsloth团队量化版本DeepSeek-R1

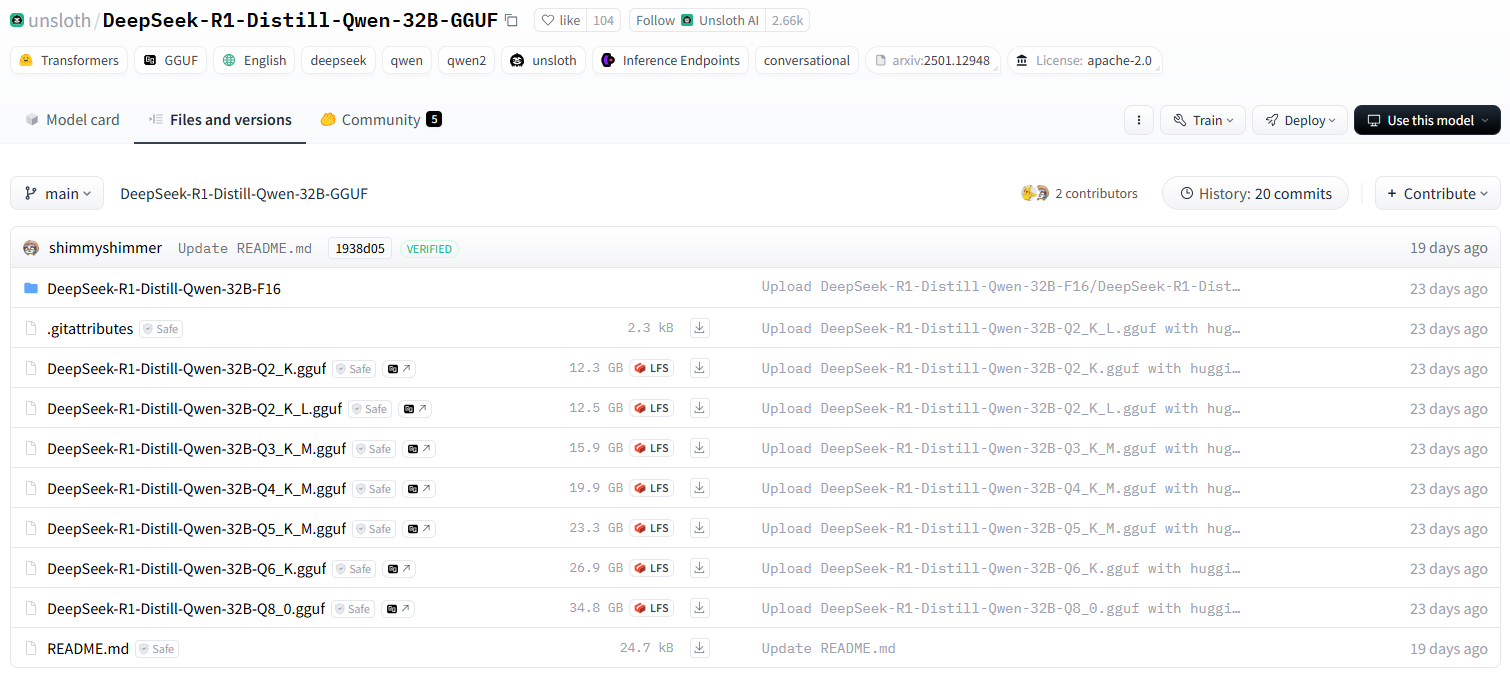

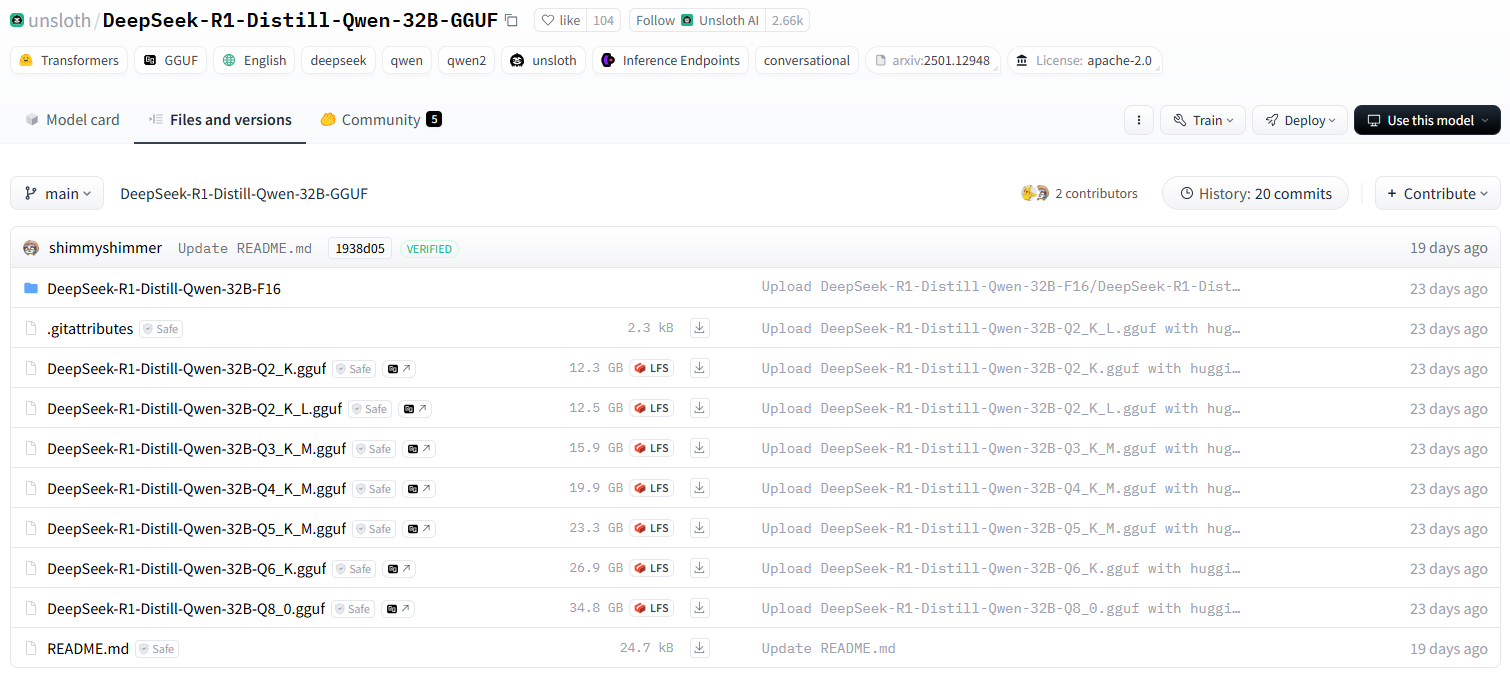

unsloth 提供的 Qwen-32B-Q4_K_M 版本直接就压缩到了20GB,已经能在消费级单卡跑了。

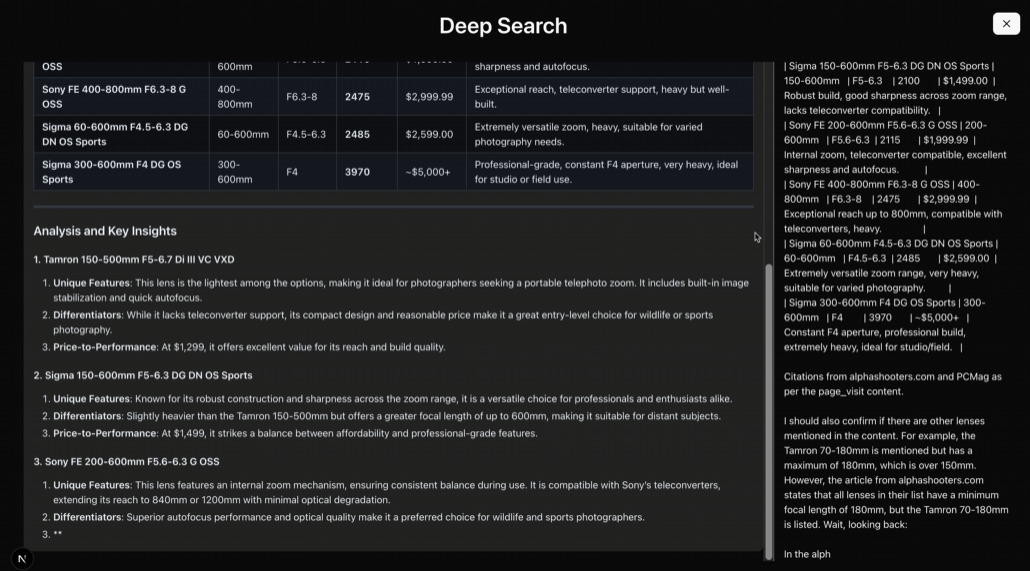

简单概括量化版本对电脑性能的要求

DeepSeek-R1-Distill-Qwen-32B-GGUF模型的不同量化版本说明

每个文件的后缀(如Q2_K_L、Q4_K_M等)代表了不同的量化。以下是它们的主要区别:

-

Q2_K_L、Q3_K_M、Q4_K_M、Q5_K_M、Q6_K、Q8_0

Q2、Q3、Q4、Q5、Q6、Q8表示计算比特数(例如Q4表示4-bit计算)。K并且M可能是不同的量化策略或精度级别。Q8_0通常是8位量化,接近FP16精度,计算需求最高但推理质量较好。

-

DeepSeek-R1-Distill-Qwen-32B-F16

F16表示16位浮点数(FP16),是未计算的模型,精度最高但占用显存最大。

在这里了解更多关于量化的概念:模型量化是什么:FP32, FP16, INT8, INT4 数据类型详解

如何选择适合的版本?

- 低显存设备(如消费级GPU) →选择Q4、Q5量化,如

Q4_K_M或Q5_K_M,兼顾性能和精度。 - 极低显存设备(如CPU运行) →选择Q2或Q3量化,如

Q2_K_L或Q3_K_M,减少内存占用。 - 高性能GPU服务器→选择Q6或Q8量化,如

Q6_K或Q8_0,获得更好的推理质量。 - 最有效→选择

F16版本,但需要大量显着存储(约60GB以上)。

免费GPU推荐安装版本

Q2_K_L

开始安装 DeepSeek-R1 32B

从如何获取免费GPU直至安装好 Ollama 过程略过,或阅读:使用免费 GPU 算力在线部署 DeepSeek-R1 开源模型,因为和之前教程唯一不同就是安装命令略有变化。

直接进入到如何在Ollama中安装特定量化版本的流程。感谢 Ollama 已经把整个安装过程简化到极致,只需学会一个安装命令即可。

1.安装huggingface量化版本模型的基础命令格式

记住以下安装命令格式

ollama run hf.co/{username}:{reponame}2.选择量化版本

所有量化版本列表:https://huggingface.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF/tree/main

此次安装使用:Q5_K_M(只为演示,再次提醒请安装免费GPU推荐的版本,Q5实际安装需要23G硬盘空间)

3.拼接安装命令

![无需本地GPU即可部署长期可用的 DeepSeek-R1 32B量化版-1 无需本地GPU即可部署长期可用的 DeepSeek-R1 32B量化版-1]()

{username}=unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF

{reponame}=Q5_K_M

拼接后得到完整安装命令:

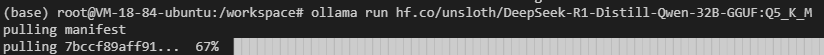

ollama run hf.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M4.在 Ollama 中执行安装

执行安装命令

![无需本地GPU即可部署长期可用的 DeepSeek-R1 32B量化版-1 无需本地GPU即可部署长期可用的 DeepSeek-R1 32B量化版-1]()

你可能会遇到网络故障(祝你好运),多重复几次安装命令…

还是不行?执行以下命令试试(切换为国内镜像地址):

ollama run https://hf-mirror.com/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M为什么不直接使用镜像地址下载,而是先用官方地址后用镜像?

因为综合安装速度较快!

当然你可能不需要这个量化版本,这里还有最近流行的未经审查版本:ollama run huihui_ai/deepseek-r1-abliterated:14b

5.让外放可以访问Ollama

在终端输入命令确认Ollama端口

ollama serve

11414或者6399

安装ngrok

curl -sSL https://ngrok-agent.s3.amazonaws.com/ngrok.asc \ | tee /etc/apt/trusted.gpg.d/ngrok.asc >/dev/null \ && echo "deb https://ngrok-agent.s3.amazonaws.com buster main" \ | tee /etc/apt/sources.list.d/ngrok.list \ && apt update \ && apt install ngrok

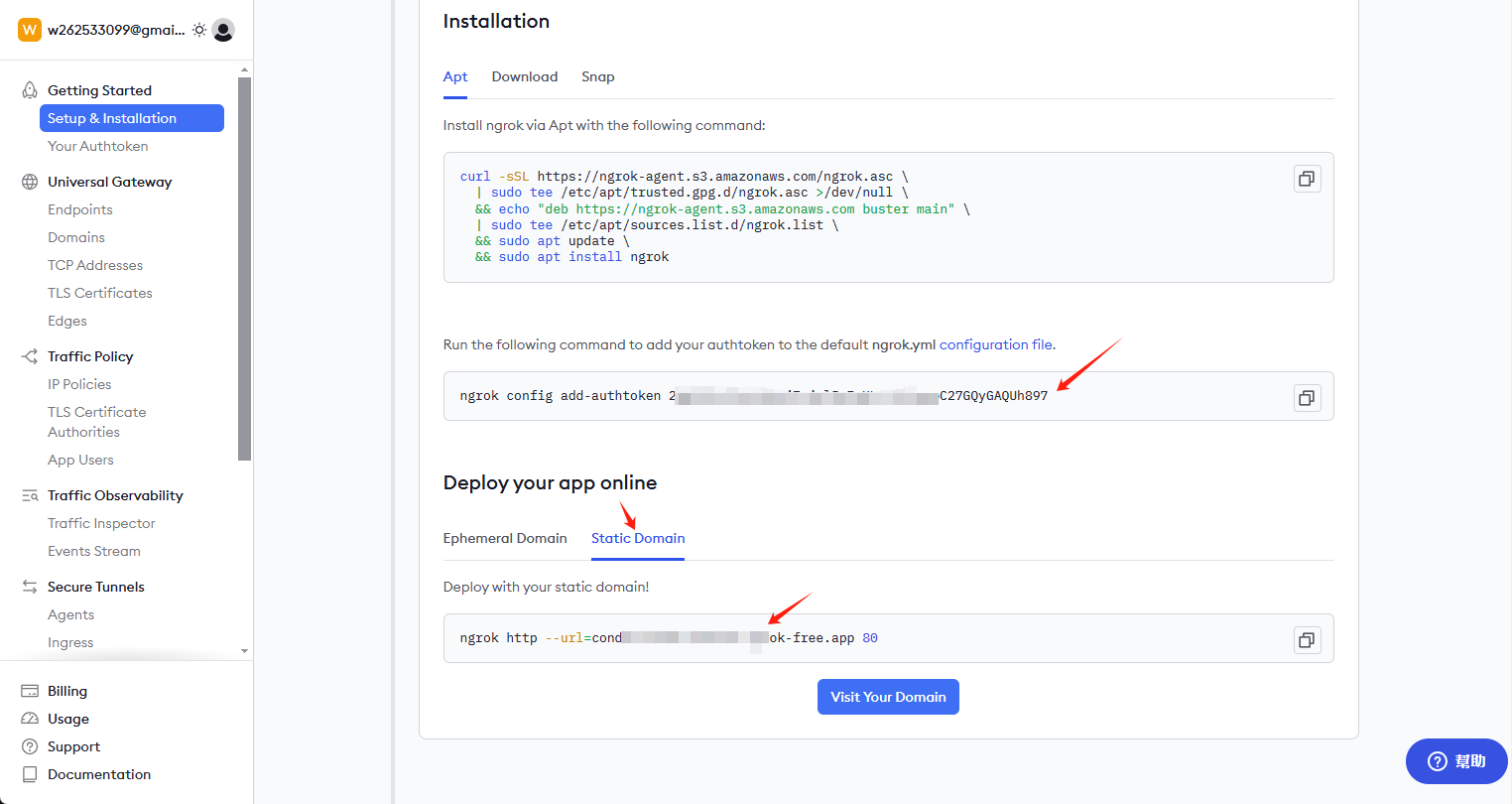

获取密钥和永久链接

访问ngrok.com注册账号,进入首页获取密钥和永久链接

![无需本地GPU即可私有化部署 DeepSeek-R1 32B-1 无需本地GPU即可私有化部署 DeepSeek-R1 32B-1]()

安装密钥并开启外部访问地址

客户端中输入以下命令:

ngrok config add-authtoken 这里是你自己的密钥

继续输入以下开启外部访问命令:6399这个端口大家可能不一样,自行查询后修改

ngrok http --url=condor-known-ferret.ngrok-free.app 6399

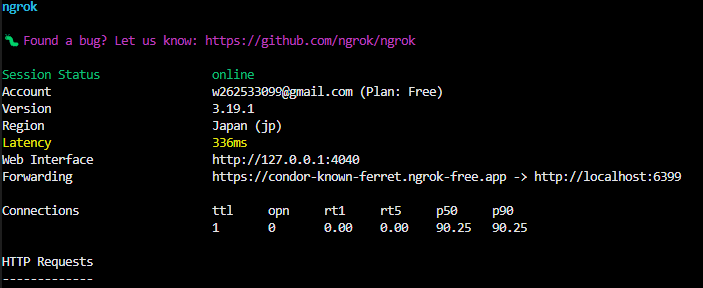

成功后你会在终端看到

![无需本地GPU即可私有化部署 DeepSeek-R1 32B-1 无需本地GPU即可私有化部署 DeepSeek-R1 32B-1]()

https://condor-known-ferret.ngrok-free.app 就是模型接口的访问地址,打开后可以看到以下内容

![无需本地GPU即可私有化部署 DeepSeek-R1 32B-1 无需本地GPU即可私有化部署 DeepSeek-R1 32B-1]()

使用

获取的https://condor-known-ferret.ngrok-free.app如何使用?

最简单的办法是安装 Page Assist 一起使用,该工具是浏览器插件,自行安装。

配置

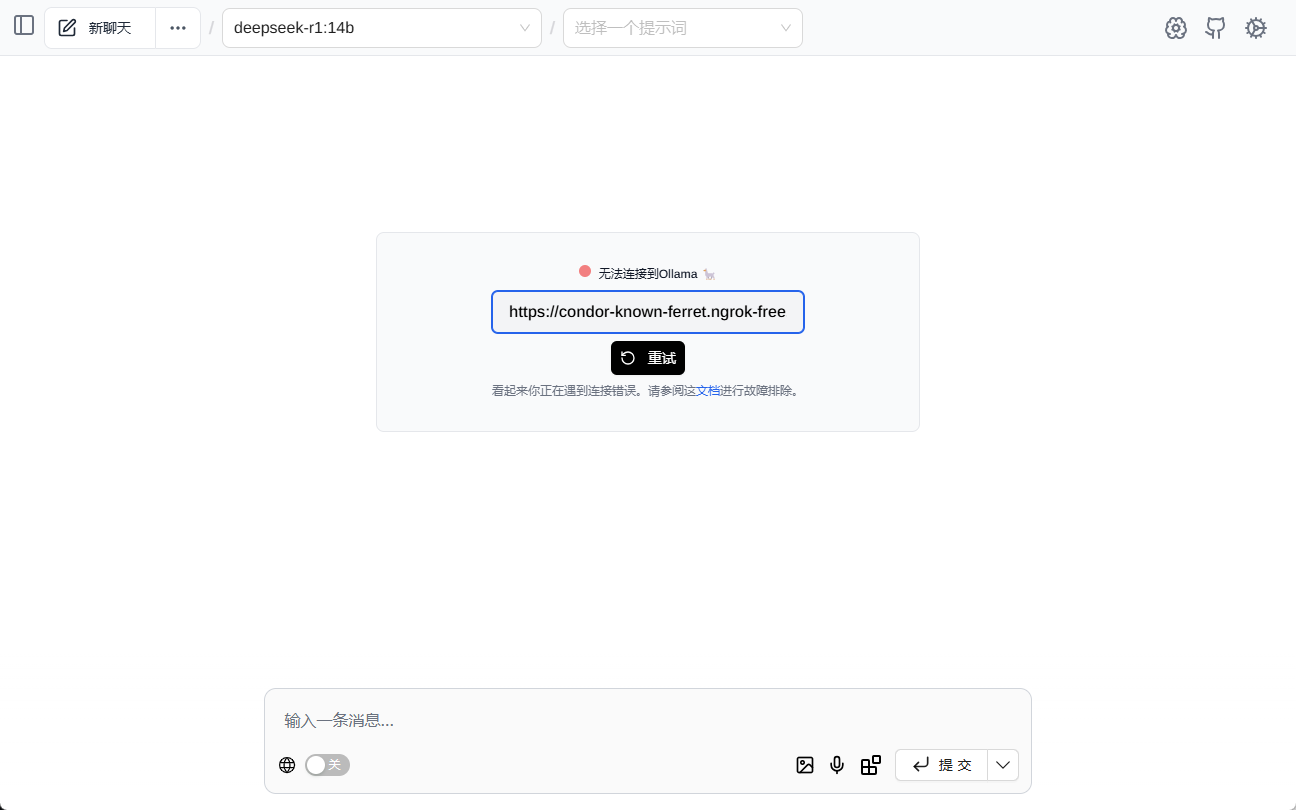

打开 Page Assist 后,你会看到如下界面,请填写接口地址

![无需本地GPU即可私有化部署 DeepSeek-R1 32B-1 无需本地GPU即可私有化部署 DeepSeek-R1 32B-1]()

正常情况下你会看到自动加载出的模型

![无需本地GPU即可私有化部署 DeepSeek-R1 32B-1 无需本地GPU即可私有化部署 DeepSeek-R1 32B-1]()

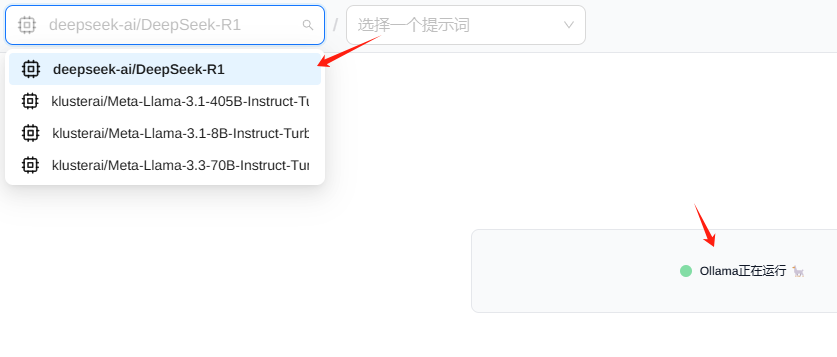

测试

![无需本地GPU即可私有化部署 DeepSeek-R1 32B-1 无需本地GPU即可私有化部署 DeepSeek-R1 32B-1]()